La historia es esta:

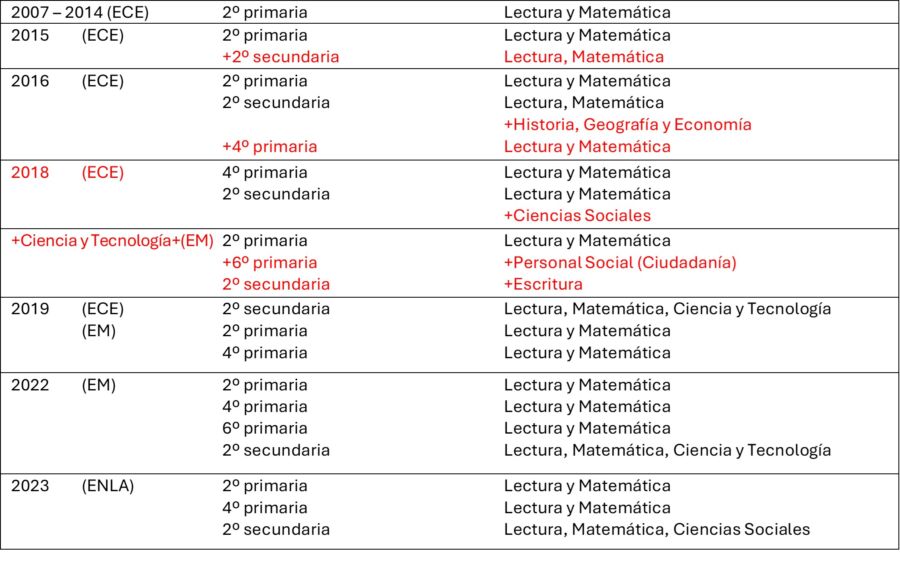

Del 2007 al 2014 se implementaron evaluaciones censales (ECE) en un solo grado (2º de primaria) y en Lectura y Matemática. Desde el 2015 se agregó 2º de secundaria en esas dos mismas áreas. El 2016 se añadió 4º grado de primaria y un área más a secundaria: Historia, Geografía y Economía, además de la permanente Lectura y Matemática. En el 2018, se agrega Ciencias Sociales y Ciencia y Tecnología a las evaluaciones censales. Además, desde ese mismo año, se distribuyen los grados y las áreas entre las evaluaciones censales de siempre y las resucitadas evaluaciones muestrales (EM). Desde el 2019 hasta la actualidad, al conjunto de todas las evaluaciones censales y muestrales se les llama Evaluaciones Nacionales de Logros de Aprendizaje (ENLA).

Puede advertirse que las evaluaciones están omnipresentes de una u otra manera: todos los años, en sus dos modalidades (censal y/o muestral), con cada vez más grados y más áreas curriculares o competencias. Se ha convertido en una rutina de diagnóstico permanente a nivel de sistema.

¿Qué es lo que sucede en las aulas? En las aulas, la evaluación formativa (y hasta cierto punto, la diagnóstica) es también constante, pues su propósito es orientar formativamente el desarrollo de las competencias en los estudiantes: se identifican estudiantes con ciertas dificultades; se proponen actividades diferenciadas; se plantean acciones compensatorias y de seguimiento; se hace retroalimentación constante; entre otras prácticas y propuestas pedagógicas de aula. Es lo que, al menos, debería pasar.

¿Qué es lo que pasa a nivel de sistema? En el caso de las evaluaciones nacionales, sus resultados retroalimentan al sistema en su conjunto, pero sobre todo al Ministerio de Educación y a las instancias regionales de educación. Esa es su función principal. También contribuyen indirectamente a la retroalimentación en las aulas, pero estas complementan su diagnóstico con las evaluaciones formativas en el día a día.

Sin embargo, nos preguntamos: ¿el sistema toma en cuenta los resultados de las evaluaciones para hacer algo? ¿qué es lo que se hace a partir de los resultados? ¿qué medidas específicas se proponen a partir de los resultados nacionales? ¿por ejemplo, focalizamos escuelas con bajos resultados? ¿hay algunos estudios o monitoreos y seguimientos confiables sobre si funcionan o no las propuestas de mejora, muy aparte de las evaluaciones estandarizadas? Así cómo se promociona la aplicación de las evaluaciones masivas y se publican sus resultados en todos los medios, ¿se divulgan con la misma fuerza las medidas que se implementan en el sector educación? ¿o es que da igual que hubiera o no evaluaciones estandarizadas porque se continúan o no haciendo las mismas cosas de siempre?

Los resultados numéricos de las evaluaciones nacionales parecen ser usados en el primer párrafo o página de toda propuesta de mejora: se identifica el problema y se lo viste del riguroso número. Pero entre uno y otro año, los números varían algo o muy poco. Los resultados de los últimos dieciséis años se resumen fácilmente en qué andamos mal: en todo; puntos más, puntos menos. Pequeñas o medianas bajas o mejoras por allí, otras por acá. La brecha urbano/rural sigue siendo amplia; puntos más, puntos menos; la minoría de estudiantes siempre parece estar en el nivel satisfactorio; puntos más, puntos menos. Las descripciones de los niveles no varían, son los mismos, y sí claro, así debería ser. Ya se entendió el mensaje. Son 16 años seguidos.

Siempre se señalaba que las calificaciones numéricas no decían mucho, aunque parecían muy objetivos y rigurosos. Por eso, en las aulas se cambió a la calificación alfabética sustentada además por una descripción cualitativa o por las llamadas “conclusiones descriptivas” que precisamente otorgan sentido a las letras (A,B,C,D).

En las evaluaciones nacionales, también hay resultados numéricos (porcentajes por nivel o medidas promedio) que distribuyen a los estudiantes en tres o cuatro niveles también fundamentados descriptivamente. Sin embargo, a nivel de sistema, parece que nos seguimos concentrando en los números como sinónimos de imparcialidad y exactitud. El objetivo de algunas instancias regionales es que las escuelas suban puntos. A eso se traducen las mejoras. ¿Por qué hemos salido tan bajos? Debemos subir porcentajes en el nivel Satisfactorio, reducir puntos en el Inicio, al menos llevar más niños al Proceso. Lo de siempre y con lo que todo el mundo parece estar de acuerdo. Todos los años son las famosas conclusiones en la escuela, la DRE o la UGEL. Los números hablan. Los números evidencian. Hay que subirlos por aquí, bajarlos por allá. Incluso, cuando se hacen los talleres de reflexión sobre los resultados, se anima a que propongan cifras de logro. Si solo el 23% de estudiantes logra el nivel Satisfactorio, entonces ¿a cuánto subiremos para el próximo año? 25%, 27%, 28%. Cifras reales por favor. Muy bien. ¿Qué hacemos para lograr subir esos puntos? Se habla de capacitaciones a lo largo del año y de entrenamiento a los estudiantes en pruebas similares pocos meses antes.

Las reflexiones de mejora se hacen a dos niveles: a) a nivel macro, nos quedamos en los números y b) a nivel de aula, lamentablemente todavía inducen a los docentes a entrenar y trabajar fundamentalmente por ficha de preguntas y por desempeños aislados; no por un enfoque curricular de competencias.

Entonces uno puede preguntarse ¿hay alguna diferencia entre los resultados de, por ejemplo, 2021 y 2023, o entre el 2015 y 2018, que hiciera que las propuestas de mejora sean distintas? cuál es la diferencia de impacto tener un 35% y un 31% sea en el nivel que sea? De ahí, preguntamos entonces, ¿es necesario que los estudiantes rindan las evaluaciones nacionales año tras año? Entendemos que las evaluaciones nacionales despiertan del letargo al sistema; los ponen en modo alerta. Es bueno cada cierto tiempo. ¿Pero todos los años? El despertar continuo se ha tornado en un insomnio persistente ¿no sería mejor hacer pausas de dos o tres años entre estas evaluaciones para que el sistema analice y reflexione con tiempo las mejoras que podría implementar? ¿no es mejor darle un respiro al sistema y, en especial, a las escuelas? ¿no sería mejor, por ejemplo, implementar y enfatizar modos de evaluación formativa en las aulas para que los docentes mismos las planteen y tengan la oportunidad de recoger evidencias de diverso tipo, en el día a día, con retroalimentaciones efectivas que permitan a los estudiantes ir mejorando en el mismo proceso de aprendizaje y sin calificaciones permanentes, entre otras posibilidades?

Lima, mayo de 2024