Fernando Llanos Masciotti | EDUCACCIÓN

Las evaluaciones censales

Sabemos que la ECE se ha venido aplicando desde el 2007 hasta el 2014 en segundo grado de primaria en Lectura y Matemática y en cuarto grado de primaria EIB en Lectura. Desde el 2015 se comenzó a aplicar la ECE también en segundo de secundaria y desde el 2016, además, en cuarto grado de primaria de Educación Básica Regular, siempre en las áreas de Lectura y Matemática. La idea era que los esfuerzos de la escuela y del sistema educativo en general no se restringieran solo a segundo grado de primaria y se ampliara la mejora en los logros de aprendizaje en los dos niveles: primaria y secundaria. De alguna manera, se quiso acabar con un excesivo protagonismo enfocado hacia los estudiantes de segundo grado de primaria con el consecuente descuido de los estudiantes de otros grados.

Por otro lado, también se abarcaron más áreas. Nuevamente con la buena intención de no solo circunscribirse a las competencias de Lectura y Matemática, se aplicó, además en el 2016, evaluaciones censales a Historia, Geografía y Economía (HGE) en segundo año de secundaria y, en este mismo grado, desde el 2018, se aplica evaluaciones de Ciencia y Tecnología (CT). De esta manera, se alcanzó una mayor cobertura de competencias evaluadas en el nivel secundaria también para evitar la restricción curricular a Lectura y Matemática.

Esto es saludable en la medida que los esfuerzos del sistema educativo no se concentran solo en uno o dos grados, sino ya en tres grados (2º y 4º de primaria, y 2º de secundaria), así como no se enfatiza solo Lectura y Matemática, sino también otras dos competencias (HGE y CT).

Sin embargo, esto acarrea algunos peligros y amenazas. Ya desde antes el uso de la ECE había generado ciertos efectos indeseables y perversos: entrenamiento mecanicista de los estudiantes en formatos de opción múltiple no solo en evaluaciones cada cierto tiempo sino en los recursos usados en procesos de enseñanza aprendizaje (fichas con preguntas con alternativas, por ejemplo); ansiedad por ganar los bonos de incentivo económicos; presión a los docentes, como si los buenos resultados solo dependieran de su desempeño; etc. Esta dinámica insertada en el sistema durante más de una década ha hecho que igualmente –y en mayor o menor medida- contamine los otros grados y áreas nuevas evaluadas. Si bien es cierto que gracias a la ECE las escuelas han puesto el foco en la diversidad textual, los procesos inferenciales de lectura, la resolución de problemas matemáticos, etc., también su uso ha generado prácticas perversas y hay cierta sensación de mareas invasivas en las escuelas por algo que estas consideran más que un apoyo a sus prácticas pedagógicas un medio de control que las presiona y señala. Pareciera que ahora la escuela se tiene que multiplicar en varios grados y áreas para mejorar los resultados numéricos y entrarle a una lógica de competencia (no la del currículo precisamente) que no necesariamente refleja la mejora en los aprendizajes.

Las evaluaciones regionales

Por supuesto, esta invasión de evaluaciones censales con mayor cobertura de grados y áreas curriculares se hace más evidente y se refuerza con el asedio de las otras evaluaciones. ¿Cuáles son estas? En primer lugar, tenemos las evaluaciones regionales (ERE), que son las que elaboran en algunas regiones las instancias de gestión locales (DRE, UGEL). Son evaluaciones que pretenden evaluar a todos los estudiantes a nivel de región. Son evaluaciones que pretenden entrenar a los estudiantes para alcanzar buenos resultados en la ECE. Estas pruebas son muy similares a los de la ECE, pero no pasan los controles de calidad pertinentes ni siguen todo el proceso riguroso que lleva a cabo la oficina encargada de diseñar, elaborar y aplicar pruebas estandarizadas (Oficina de Medición de Calidad de Aprendizajes- UMC). Asimismo, son los mismos docentes quienes la aplican al menos dos o tres veces al año, especialmente cuando ya se va a cercando la ECE. Muchas veces las escuelas se tienen que encargar de imprimirlas. Por otro lado, las escuelas no tienen claro la procedencia de las evaluaciones. Creen que todas son evaluaciones censales que aplica el Ministerio de Educación. En otras palabras, para muchas escuelas, las ECE y las ERE son lo mismo. No hacen distinción de qué viene del Ministerio y qué viene de las DRE o UGEL, pues tienen el mismo formato y ambas aparecen con el logo del Minedu. Lo cierto es que la invasión de las ECE viene multiplicada por la presencia de las evaluaciones regionales.

Los kits de evaluación

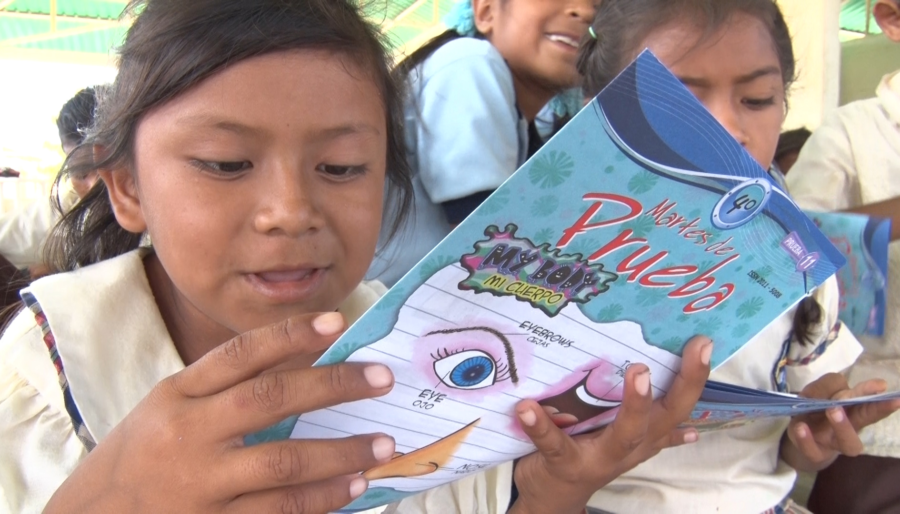

Pero las evaluaciones regionales no son las únicas que asaltan masivamente las escuelas. También tenemos, en segundo lugar, el kit de evaluación propuesto por el Minedu desde hace años. Son evaluaciones que aparecen en la página web también llamadas “Demostrando lo que aprendimos”. Si bien pretenden ser evaluaciones de aula (hay preguntas abiertas, viene con guías que orientan cómo debe retroalimentarse, se indica a qué capacidad o desempeño viene ligada cada pregunta) se nota una clara tendencia y sesgo de evaluaciones de sistema (tiempo de duración, la mayoría son preguntas de opción múltiple, en fin, el formato es de una evaluación nacional y estandarizada). Se presentan en un formato en el que se recomienda proponerse en las aulas tres veces al año en segundo y cuarto grado de primaria (I, II y III trimestre) así como en segundo año de secundaria (Entrada, Proceso, Salida). De hecho, es a partir de este kit de evaluación que las regiones comenzaron a implementar sus evaluaciones regionales tomándolas como modelo. Algunas de estas evaluaciones regionales simplemente son kits de evaluación aplicados masivamente.

Las evaluaciones muestrales

En tercer lugar, otro tipo de evaluación nacional que ha irrumpido en las aulas es el de la evaluación muestral (EM). Desde el año 2013, se aplicó, después de casi una década, una evaluación muestral en 6º grado de primaria en Lectura, Escritura, Matemática y Ciudadanía.

A diferencia de una evaluación censal, que es una evaluación estandarizada que se aplica a todos los estudiantes de un país, la evaluación muestral se aplica a una muestra representativa de estudiantes a nivel nacional. Otra diferencia es que este tipo de evaluación permite una mayor cobertura curricular, es decir, se puede cubrir más capacidades y desempeños gracias a que hay una mayor cantidad de preguntas, en las que se incorporan una considerable cantidad de ítems de respuesta construida (tareas que demandan redactar brevemente una respuesta). Estas preguntas abiertas permiten evaluar habilidades complejas como son las de argumentación, juicio crítico, explicación, procedimientos y estrategias en la resolución de un problema, toma de decisiones en la que se evidencia una justificación razonada y coherente. Estas preguntas abiertas implican explorar e indagar por habilidades que no pueden ser evaluadas a través de ítems de opción múltiple y de alguna manera pueden darnos algunos indicios del pensamiento crítico en las diversas competencias evaluadas.

Es muy valiosa la presencia de este tipo de preguntas abiertas en las evaluaciones muestrales en comparación con las censales. Por ejemplo, de un centenar de preguntas en la Evaluación Muestral del año 2013 se incluyeron 22 preguntas abiertas en el área de Matemática, 34 de Lectura, 26 de ciudadanía y 2 consignas para redactar en escritura. Por el contrario, por ejemplo, en la prueba de Ciudadanía de la Evaluación Censal, solo hay 3 preguntas abiertas.

Asimismo, para la evaluación muestral se recoge información de factores asociados. Para ello se aplican cuestionarios a distintos actores de la comunidad educativa: estudiantes, docentes y padres de familia, así como fichas de observación para registrar información sobre la institución educativa. En estos cuestionarios se indaga, por ejemplo, por los conocimientos y las creencias de los docentes sobre la didáctica de alguna competencia; por el capital cultural de los padres y madres de familia; por las necesidades e intereses de los estudiantes; etc. Todo ello puede explicar, en parte, los resultados de las evaluaciones.

Las evaluaciones muestrales no comenzaron realmente a aplicarse el año 2013. La primera se llamó Crecer 1996. Luego continuaron Crecer 1998, Evaluación Nacional (EN) 2001 y la EN 2004. La EN 2008 abortó por la aparición en escena de la Evaluación Censal en el año 2007. Las evaluaciones muestrales se daban cada cuatro años. La última evaluación de ese periodo, la EN 2004, evaluó Lectura, Escritura, Matemática y Ciudadanía en 2º y 6º de primaria, y 3º y 5º año de secundaria.

Luego vino la EM 2013, que resucitó las evaluaciones de carácter muestral desde el año 2004, que fue la última evaluación de este tipo. Sin embargo, luego de la EM 2013, el asedio masivo de evaluaciones estandarizadas se comenzó a dar desde el año 2018 y parece que esa va a ser la tendencia de ahora en adelante.

Así, a finales del año 2018, la UMC llevó a cabo una evaluación de carácter muestral con el propósito de ofrecer información sobre el nivel de aprendizaje en los siguientes grados y áreas: 2° de primaria (Matemática y Lectura), 6° de primaria (Ciudadanía) y 2° de secundaria (Escritura). Y, para este año 2019, se va a aplicar nuevamente una evaluación muestral en 2º y 4º de primaria en Lectura y Matemática. Todo ello, de forma paralela, con la aplicación de las ECE.

La alternancia y frecuencia de las evaluaciones censales y muestrales

De esta manera, a nivel nacional, entre las censales y las muestrales, se intenta cubrir, al parecer -y paulatinamente- todos los grados finales de ciclo y competencias curriculares. La alternancia parece obedecer a las buenas intenciones de que la escuela esté alerta de lograr mejores aprendizajes en todos los ciclos y competencias. Sin embargo, esto se distorsiona al momento de los usos y mensajes, pues nuevamente está el esfuerzo por lograr mejores números desde todo el sistema educativo y no necesariamente mejores logros de aprendizaje con procesos permanentes de enseñanza aprendizaje.

Por otro lado, está el problema de la frecuencia anual con la que van a realizarse las muestrales y que es una carga heredada de las evaluaciones censales (y de todas las otras evaluaciones que hemos descrito, tales como las evaluaciones regionales y los kits de evaluación). De hecho, las evaluaciones muestrales del 2018 y 2019 repiten la evaluación de 2º grado de primaria en Lectura y Matemática. La frecuencia anual con que se aplicaban las censales ha sido trasladada también a las muestrales y, al parecer, con especial énfasis en 2º grado de primaria. Si bien es cierto que la intención de pasar la ECE segundo grado de primaria a una evaluación muestral obedece a evitar el efecto perverso de concentrar los esfuerzos solo en un grado, esto no funciona del todo pues en las escuelas no ven gran diferencia entre las censales y las muestrales como tampoco la ven entre las censales y las regionales. Son solo evaluaciones para las que hay que preparar y entrenar a los estudiantes a costa de desarrollar procesos de enseñanza aprendizaje de calidad.

La frecuencia anual con que se aplicaban las censales tenía el objetivo de ver la evolución de los aprendizajes en el tiempo. El problema es que la expectativa de que subieran los resultados (perdón, los aprendizajes) parecía ser de año por año. Esta expectativa inmediata, cortoplacista, no se podía lograr con capacitaciones, compromisos, bonos motivadores, presión de directores e instancias locales y nacionales sino con recursos también inmediatos y a la mano, es decir, evaluaciones de entrenamiento y afines. Estos podían ser más efectivos. El mensaje consciente o no consciente del Minedu sobre cómo usar los resultados era “lograr el satisfactorio” porque eso era lograr los estándares curriculares. Pero ya. Pronto. El próximo año. No en los estudiantes a los que ya se había aplicado, sino a la próxima promoción. Correr contra el tiempo. Apresurar los procesos de enseñanza. Marginar a los estudiantes que no iban al mismo ritmo. Cerrar las puertas a los menos hábiles el día de la prueba. Señalar a los docentes y escuelas que no habían logrado mejorar los porcentajes de estudiantes en el Satisfactorio. Hay muestras de que ese afán controlista del desempeño de los docentes se está saliendo precisamente de control. Porque eso es lo que también se percibe. Si bien ahora el docente tiene actualmente un rol más protagónico y hay cierto esfuerzo por contribuir a mejorar su desempeño profesional, también es cierto que se siente más observado, presionado y fiscalizado (acompañamiento pedagógico, monitoreo, semáforo escuela, etc.). A esto habría que sumarle la invasión de evaluaciones estandarizadas cuyo uso además pervierte a las evaluaciones de aula tan disminuidas y silenciadas cada vez más y más desde hace mucho tiempo. Por un lado, desde el Minedu se promueve la evaluación formativa (evaluación procesual) en las aulas, pero a la vez se incentiva las evaluaciones estandarizadas (evaluación de producto) por todos los flancos. Se aclara que la evaluación formativa no necesariamente implica calificaciones, pero se promueve la competencia de porcentajes en los niveles de logro propuestos en las evaluaciones nacionales. Contradicciones o tensiones que son necesarias de resolver y quedan aún pendientes.

Por otro lado, ¿realmente mejorar los aprendizajes implica solo proyectar porcentajes? ¿es posible proyectar cuántos estudiantes lograrán tal o cual año el nivel Satisfactorio? ¿o el nivel En proceso? ¿Un director puede proyectar que este año el 37% de sus estudiantes de cuarto de primaria logrará el nivel satisfactorio considerando que el año pasado lo logró el 26%? ¿Cómo se puede hacer eso desde la escuela, desde la UGEL o DRE? La única respuesta inmediata parece ser la de aplicar pruebas parecidas, como un reflejo automático. No se tiene otro referente. Son las evaluaciones nacionales las que me dan un referente de números para adoptar compromisos. Es perfectamente comprensible que las escuelas se vean arrinconadas a esa dinámica creada por el propio sistema en su conjunto queriendo o sin querer. Se proyectan “números” sentados en carpetas; no niños, niñas y adolescentes.

Entonces, ¿era necesaria la frecuencia anual en las censales? Si vemos los resultados, los puntos que bajan o suben entre el 2007 y 2018 no son tan, digamos, espectaculares, excepto tres o cuatro años. En general, nos siguen diciendo lo mismo. En esencia. Que a los polidocentes y urbanos les va mejor que a los multigrado y rurales. Que a Moquegua y Tacna les va mejor que Loreto y Ucayali. Que las dificultades, por ejemplo, en Lectura, se relacionan con habilidades inferenciales de carácter global (tema central, propósito del texto, comparaciones) y reflexión sobre la forma, así como la diversidad textual en primaria. Y en Matemática la resolución de problemas. Es más de lo mismo. En todo caso, cierto es que hay insumos sumamente valiosos y ricos en los informes pedagógicos de la ECE y de la EM que de alguna manera pueden orientar la discusión al interior del Minedu sobre las potencialidades, dificultades y fortalezas de los estudiantes sobre las competencias evaluadas. Pero para eso se necesita tiempo para reflexionar y tomar decisiones. No son solo para el próximo año. No son solo para una gestión.

¿Mejorar porcentajes o aprendizajes?

Cabe recordar, asimismo, que el entrenamiento no siempre logra esos efectos inmediatos de mejoras numéricas consistentes (por eso los mejores porcentajes en el Satisfactorio tienen su techo; no van a ir más allá de ciertos números), pues los resultados no dependen solamente de las estrategias del docente a secas, sino de un docente que el mismo sistema educativo ha preparado a través de Institutos Superiores Pedagógicos y facultades de educación. Pero otra vez, no solo depende del docente a secas ni del docente bien o mal formado por el propio sistema, sino de las características socioeconómicas de las familias de los estudiantes, del capital cultural de sus hogares, de su situación bilingüe, de la diversidad de edades y grados en aulas multigrado, de la infraestructura y servicios de las escuelas, de la llegada de materiales a tiempo, etc., es decir, en general, de las condiciones de los estudiantes y de las escuelas, y no solo del desempeño docente.

Hay, pues, una gran brecha no solo entre los resultados en las escuelas rurales y urbanas o entre las escuelas polidocentes y multigrado, sino entre lo que el sistema da y lo que este mismo exige.

Por todo ello, sería interesante y quizás más provechoso aplicar solo evaluaciones muestrales y ya no censales y, además, que se den no anualmente sino cada tres años, de manera que el sistema educativo en su conjunto se den espacios para reflexionar y tomar mejores decisiones -no solo basadas en porcentajes- con la finalidad de mejorar de verdad la calidad de los aprendizajes, es decir, ir más allá de las evaluaciones nacionales. Para un mejor aprovechamiento de los resultados de las evaluaciones no se necesita tomar la temperatura a cada instante. No es el termómetro lo que va a mejorar la salud. No es necesario aplicar una gran cantidad de evaluaciones ni que estas sean repetidas anualmente con un claro sesgo censal.

Para ello, las escuelas necesitan tiempo para recomponerse y, en especial, el Minedu, pues es el ente que debe tomarse tiempo para reflexionar y tomar decisiones y acciones para implementar mejoras no solo a corto sino a mediano y largo plazo. Ese tiempo no se aprovecha de la mejor manera si anualmente se bombardea con evaluaciones de todo tipo a las escuelas y al mismo sistema educativo en su conjunto. No hay tiempo para procesar la información que parece abundante y compleja, pero que a la vez dice lo mismo. No da tiempo porque todo el sector educación tiene un año para mejorar los resultados de las evaluaciones a diferentes niveles. Y justamente los procesos de enseñanza aprendizaje de los estudiantes no se pueden dar a la carrera en las aulas ni tampoco nivelarlos en un año pasando por encima de sus necesidades y ritmos de aprendizaje.

Lima, 11 de noviembre de 2019